Tu as sûrement déjà discuté avec un chatbot, que ce soit pour demander de l’aide sur un site web, poser une question à un assistant vocal ou simplement tester ChatGPT. Mais as-tu déjà pris le temps de te demander comment ces agents conversationnels arrivent à comprendre et répondre à tes questions ? 🤔

Derrière leur apparente simplicité, les chatbots reposent sur des technologies avancées comme le traitement du langage naturel (NLP) et l’intelligence artificielle (IA). Ils sont capables de traiter des phrases humaines, d’en analyser le sens et de formuler des réponses adaptées. Aujourd’hui, découvrons les coulisses de ces machines pour mieux les comprendre ! 🚀

Qu’est-ce qu’un chatbot ? 🤖

Un assistant virtuel taillé pour l’interaction

Un chatbot, c’est un programme informatique conçu pour simuler une conversation avec un humain. Il peut répondre à des questions, fournir des informations et même exécuter certaines tâches comme prendre un rendez-vous ou recommander un produit.

Il existe deux grandes catégories de chatbots :

- Les chatbots basiques 📋

👉 Ils suivent un script prédéfini et ne comprennent pas vraiment le sens des phrases. Leur logique repose sur des arbres de décision où chaque réponse est associée à un mot-clé précis.

Un chatbot de FAQ sur un site e-commerce qui te répond avec des réponses toutes faites selon les mots que tu utilises. - Les chatbots intelligents (IA) 🧠

👉 Ils utilisent des technologies avancées comme le traitement du langage naturel (NLP) et le machine learning. Ces chatbots sont capables d’apprendre de nouvelles phrases, de comprendre le contexte d’une conversation et d’adapter leurs réponses en fonction de ce que tu dis.

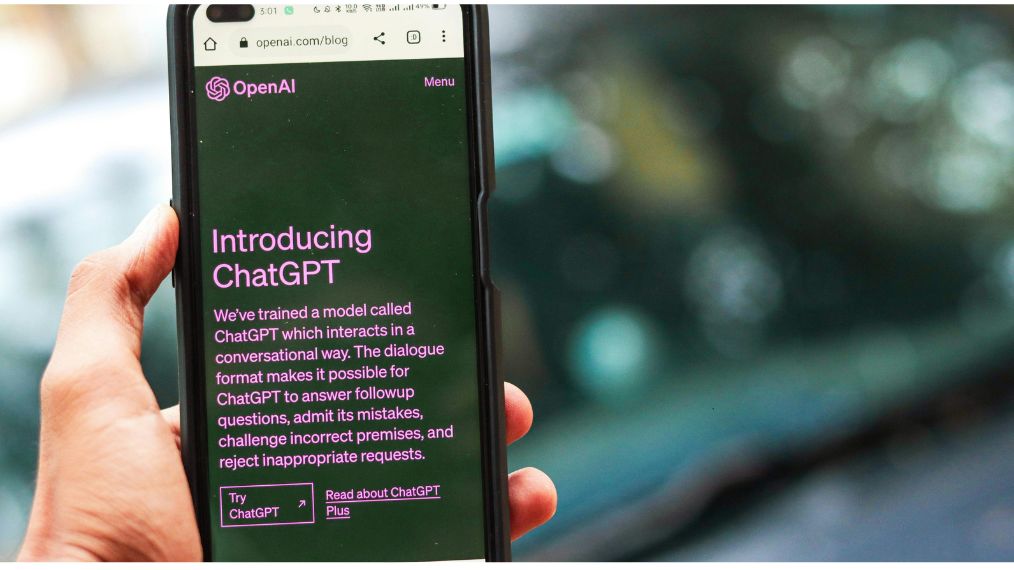

ChatGPT, Siri ou Google Assistant qui peuvent interpréter des phrases complexes et interagir de manière fluide.

Le Machine Learning et le Deep Learning, c’est quoi ?

Le Machine Learning (et sa sous-catégorie, le Deep Learning) permet aux ordinateurs d’apprendre seuls en analysant des données. C’est grâce à ça que Netflix te recommande des séries, que les voitures autonomes roulent sans conducteur et que ta boîte mail bloque les spams. L’ordi devient plus intelligent à force d’apprendre… un peu comme toi en révisant ! 😏

🎯 Pourquoi sont-ils devenus si populaires ?

L’utilisation des chatbots a explosé ces dernières années pour plusieurs raisons :

- Automatiser le service client et répondre aux utilisateurs 24/7.

- Personnaliser l’expérience utilisateur, notamment en e-commerce.

- Optimiser les coûts en réduisant la charge de travail des conseillers humains.

- Analyser les conversations pour mieux comprendre les besoins des clients.

Tu l’auras compris, les chatbots sont partout et sont devenus de véritables assistants intelligents pour les entreprises… et pour nous, utilisateurs du quotidien. 😊

Besoin d’un prof particulier d’informatique ? ✨

Nos Sherpas sont là pour t’aider à progresser et prendre confiance en toi !

Les briques technologiques d’un chatbot IA 🧱

Un chatbot intelligent, c’est un peu comme une recette de cuisine sophistiquée : plusieurs ingrédients techniques doivent être combinés pour obtenir un assistant performant. On va maintenant voir les trois briques technologiques essentielles qui permettent à un chatbot de comprendre et de répondre à une conversation.

Le traitement du langage naturel (NLP)

Le Natural Language Processing (NLP) est la technologie qui permet aux machines de comprendre, d’interpréter et de générer du texte en langage humain. C’est grâce à lui qu’un chatbot ne se contente pas de chercher des mots-clés, mais qu’il analyse le sens global d’une phrase.

Comment fonctionne le NLP ?

Le NLP passe par plusieurs étapes :

- La tokenisation

- Chaque phrase est découpée en unités de sens appelées « tokens » (mots, groupes de mots, ponctuation).

- « Quel est le prix d’un abonnement ? » → [‘Quel’, ‘est’, ‘le’, ‘prix’, ‘d’un’, ‘abonnement’, ‘?’]

- L’analyse syntaxique et grammaticale

- Le chatbot identifie la structure de la phrase et le rôle de chaque mot (verbe, sujet, complément).

- « Je veux réserver un billet » → Il comprend que « réserver » est le verbe d’action.

- L’analyse sémantique

- L’IA détecte le sens global de la phrase et résout les ambiguïtés.

- « Je veux réserver un billet » (voyage ?) VS « Je veux réserver un livre » (bibliothèque ?).

- La compréhension du contexte

- Un bon chatbot ne se limite pas à comprendre une phrase isolée, il suit toute la conversation.

- Si tu dis « Je veux commander une pizza » puis « Ajoute des champignons », il sait que « Ajoute » fait référence à la pizza.

Le NLP est donc l’élément central qui permet à un chatbot de comprendre ce que tu lui dis avec des phrases naturelles et non des commandes rigides.

Les algorithmes d’apprentissage automatique (Machine Learning) 🦾

Un chatbot IA ne fonctionne pas avec une simple liste de questions-réponses, il apprend grâce à des modèles d’intelligence artificielle. C’est ce qu’on appelle le Machine Learning (apprentissage automatique).

Comment un chatbot apprend-il ?

Le chatbot est entraîné sur d’énormes bases de données contenant des millions d’exemples de conversations humaines. Il ajuste ses réponses grâce à plusieurs techniques :

- L’apprentissage supervisé

- Des développeurs fournissent des milliers de paires « question → réponse correcte ».

- Le chatbot apprend à reconnaître des schémas et à associer une question à la meilleure réponse possible.

- L’apprentissage non supervisé

- L’IA analyse de gros volumes de conversations et repère seule les liens entre les mots et expressions.

- Cela permet au chatbot de détecter de nouvelles façons de poser une question.

- L’apprentissage par renforcement

- Le chatbot teste différentes réponses et reçoit un score selon leur pertinence.

- Plus il obtient de bons scores, plus il affine ses réponses et devient performant.

C’est grâce à ces techniques qu’un chatbot s’améliore en continu, en s’adaptant à chaque nouvelle interaction.

L’utilisation des modèles de langage (LLM) 💾

Les chatbots les plus avancés (comme ChatGPT) utilisent des modèles de langage massifs appelés LLM (Large Language Models). Ces modèles ont appris des milliards de phrases et sont capables de générer des réponses de manière fluide et cohérente.

Pourquoi les LLM sont-ils si puissants ?

- Ils comprennent le contexte d’une conversation sur plusieurs échanges.

- Ils peuvent générer du texte naturel, comme s’ils étaient humains.

- Ils s’adaptent au ton et au style de l’utilisateur.

Si tu parles à un chatbot avec des tournures familières, il pourra répondre sur le même ton. Si tu lui poses une question technique, il adoptera un langage plus formel.Grâce à ces modèles, les chatbots IA ne se contentent plus de simples réponses programmées : ils s’expriment avec une fluidité qui les rend presque « humains ». 😮

🔥 Récap’ rapide des briques technologiques

✔️ Le NLP permet au chatbot de comprendre tes phrases en analysant la grammaire et le sens.

✔️ Le Machine Learning l’aide à apprendre et à affiner ses réponses au fil du temps.

✔️ Les modèles de langage (LLM) rendent ses réponses plus naturelles et adaptatives.

C’est grâce à tout ça qu’un chatbot est capable de discuter avec toi de façon intelligente et fluide.

Les sources d’apprentissage et la base de connaissances 🌱

Un chatbot IA n’est pas une boule de cristal qui connaît tout par magie. Pour répondre correctement aux questions, il s’appuie sur une base de connaissances qui lui sert de référence.

Les bases de connaissances statiques : le socle de l’IA

Certains chatbots fonctionnent avec un ensemble de réponses pré-enregistrées dans une base de données. Ces informations sont rédigées par des experts et couvrent les questions les plus fréquentes des utilisateurs.

Ton premier cours particulier d’informatique est offert ! 🎁

Tous nos profs sont passés par les meilleures écoles de France !

Exemples de bases de connaissances statiques :

- FAQ classiques (questions-réponses sur un produit ou un service).

- Bases documentaires (encyclopédies, manuels techniques).

- Dictionnaires et bases linguistiques (pour la compréhension des mots et des tournures).

⚠️ Limite : Un chatbot basé uniquement sur une base statique ne peut pas s’adapter aux nouvelles questions ou aux variations de langage. Si une question ne correspond pas exactement à un modèle enregistré, il risque de répondre « Je ne comprends pas ».

À lire aussi

Les bases de connaissances dynamiques : une IA qui évolue

Les chatbots intelligents ne se limitent pas à des réponses figées. Ils sont capables d’accéder à des données mises à jour en temps réel pour améliorer leur pertinence.

Où vont-ils chercher ces infos ?

- Sur Internet

- Certains chatbots, comme Bard ou ChatGPT (via son mode navigation), peuvent consulter des articles récents, des actualités, voire des bases de données scientifiques.

- Si tu demandes « Quel est le dernier classement FIFA des équipes de foot ? », un chatbot connecté pourra chercher cette info sur des sites spécialisés.

- Dans des bases internes

- Les entreprises entraînent leurs chatbots sur des données propriétaires (par exemple : service client, documentation interne, CRM).

- Un chatbot d’assistance technique peut te donner des instructions précises sur un produit spécifique.

- Par apprentissage en continu

- Certains chatbots sont conçus pour mémoriser les conversations et ajuster leurs réponses en fonction des échanges passés.

- Si un chatbot reçoit souvent une question mal comprise, ses créateurs peuvent améliorer sa réponse pour la prochaine fois.

Ces bases dynamiques permettent aux chatbots de progresser avec le temps et de proposer des réponses plus adaptées aux demandes des utilisateurs.

À lire aussi

La recherche de ces infos créé parfois des ennuis : ça te dit quelque chose, le vol des données de l’IA ?

L’importance du fine-tuning et du feedback utilisateur

Un chatbot efficace, ce n’est pas juste un gros paquet de données qu’on balance dans une IA. Il faut lui apprendre à bien utiliser ces informations.

Le fine-tuning : affiner un chatbot pour un usage spécifique

- Un modèle de base (comme GPT-4) peut être spécialisé en l’entraînant sur un ensemble de données propre à un domaine.

- On peut entraîner une version de GPT-4 pour qu’il devienne un expert en médecine ou en droit.

Le feedback des utilisateurs : un moteur d’amélioration

- Les interactions avec les utilisateurs permettent d’identifier les failles et d’améliorer le chatbot.

- Certains chatbots demandent même un retour utilisateur : « Cette réponse vous a-t-elle aidé ? » 👍👎

En résumé : d’où viennent les connaissances d’un chatbot IA ?

✔️ Bases statiques : FAQ, documents, bases de données fixes.

✔️ Bases dynamiques : mises à jour en temps réel via Internet ou bases internes.

✔️ Apprentissage continu : affinage du modèle grâce au fine-tuning et aux retours des utilisateurs.

L’interaction avec l’utilisateur : dialogue et compréhension du contexte 🗣️

Un chatbot ne se contente pas d’afficher une réponse basique après une question. Pour donner l’impression d’un échange naturel, il doit comprendre le contexte et s’adapter à la conversation en temps réel.

Les étapes du dialogue entre l’utilisateur et le chatbot

Un échange avec un chatbot passe par plusieurs étapes avant d’aboutir à une réponse pertinente :

- L’utilisateur pose une question

- « Où puis-je trouver des billets de train ? »

- Le chatbot analyse la phrase

- Détection des mots-clés : « trouver », « billets », « train ».

- Compréhension du contexte : recherche d’un service de réservation.

- Il consulte sa base de connaissances

- Vérification des sources disponibles (FAQ, API de réservation, etc.).

- Il génère une réponse adaptée

- « Tu peux acheter des billets sur [Nom du site] ou via leur application mobile. »

- Il attend un éventuel suivi

- « Tu cherches un billet pour quelle destination ? »

Ce processus est répété en boucle pour chaque interaction, rendant la conversation fluide et interactive.

Comment un chatbot peut-il suivre le fil d’une conversation ?

Si un chatbot était incapable de mémoriser les échanges précédents, tu serais obligé de tout répéter à chaque message. 😤 Heureusement, l’IA peut retenir les informations clés pour assurer une meilleure continuité.

Les variables contextuelles : la mémoire à court terme du chatbot

- Lorsqu’un utilisateur fournit une info comme « Je veux un billet pour Paris », le chatbot la stocke temporairement.

- Cela lui permet de répondre intelligemment à des questions suivantes comme « Et pour le retour ? ».

L’intention et l’entité : les deux clés de la compréhension

- L’intention : ce que veut réellement dire l’utilisateur.

- « Je veux un billet de train » = intention d’achat.

- Les entités : les éléments spécifiques extraits de la phrase.

- « Paris » (destination), « demain » (date), « 1ère classe » (option).

Grâce à ces éléments, un chatbot peut adapter ses réponses au contexte et améliorer l’expérience utilisateur.

Les limites et défis de la compréhension contextuelle 🚧

Même si les chatbots sont de plus en plus performants, ils ont encore des faiblesses :

❌ Problèmes d’ambiguïté

- « Je veux réserver une table. » → Restaurant ? Salle de réunion ? Jeu d’échecs ?

- Le chatbot doit poser des questions complémentaires pour éviter toute confusion.

❌ Difficulté à gérer les longues conversations

- Les chatbots IA comme ChatGPT mémorisent mieux le contexte, mais certains modèles ont encore du mal à retenir les informations sur plusieurs échanges.

❌ Mauvaise compréhension des émotions

- Un chatbot peut détecter les sentiments (colère, joie…), mais il n’a pas d’émotions réelles et peut parfois donner des réponses inadaptées.

L’amélioration continue doit donc être travaillée :

- Les développeurs testent et affinent les modèles pour qu’ils deviennent plus intuitifs et réactifs.

- Certains chatbots intègrent des emojis et des réponses empathiques pour améliorer l’expérience.

Un chatbot efficace doit non seulement comprendre les mots, mais aussi le contexte et l’intention derrière chaque message.

À lire aussi

Récap’

✔️ Un chatbot suit un processus en plusieurs étapes pour répondre intelligemment.

✔️ Il utilise les intentions et entités pour comprendre la demande.

✔️ Il mémorise le contexte pour des interactions plus naturelles.

✔️ Il rencontre des limites, mais progresse grâce aux nouvelles avancées en IA.

Les défis et limites des chatbots IA 🚫

Même si les chatbots IA sont impressionnants, ils ne sont pas encore parfaits. Leur développement rencontre plusieurs défis techniques, éthiques et même culturels. On va voir ensemble les limites actuelles des chatbots et les solutions envisagées pour les améliorer.

Compréhension imparfaite du langage humain

Les humains peuvent jouer sur les mots, faire des blagues, employer des métaphores… Mais un chatbot, lui, ne capte pas toujours ces subtilités.

Exemples :

- « Peux-tu me dire où acheter un billet ? » → Aucun problème de compréhension.

- « J’aimerais mettre la main sur un ticket. » → Il peut ne pas saisir l’expression idiomatique.

- « J’ai besoin d’une place » → Billet de train ? Siège au théâtre ? Parking ?

Pour améliorer les modèles de langage, il faut les exposer à plus d’expressions en leur apprenant à poser des questions pour clarifier une demande.

Problèmes de mémoire et suivi du contexte 🧐

Un bon chatbot doit pouvoir retenir les informations d’un échange, mais cette mémoire a ses limites.

Exemple :

Utilisateur : « Je veux réserver un billet pour Marseille. »

Chatbot : « Pour quelle date ? »

Utilisateur : « Dimanche. »

Chatbot : « Pour quelle destination ? » (Il a oublié que tu voulais aller à Marseille !)

Certains modèles avancés, comme ChatGPT et Claude, utilisent une mémoire contextuelle améliorée pour ne pas perdre le fil. Des techniques comme les « context windows » permettent aux chatbots de garder en mémoire un plus grand nombre d’échanges récents.

Manque d’émotions et d’empathie réelle 🎭

Même si certains chatbots sont programmés pour imiter l’empathie (« Je comprends votre frustration »), ils ne ressentent rien.

Pour te permettre de visualiser :

- Un utilisateur en détresse demande de l’aide → Le chatbot répond de manière trop neutre ou hors sujet.

- Une demande humoristique → Le chatbot ne comprend pas le second degré.

Pour résoudre le problème, il faut Intégrer des modèles d’analyse des émotions pour ajuster le ton des réponses. Et ainsi permettre aux chatbots de passer le relais à un humain si l’utilisateur exprime du stress ou de la détresse.

Dépendance aux données et biais algorithmiques 🫤

Les chatbots IA apprennent à partir de milliards de textes trouvés sur Internet… mais ça pose des problèmes.

Quels sont les risques ? :

- Données biaisées : un chatbot peut répéter des stéréotypes s’il a appris sur des textes discriminants.

- Mauvaises sources : si l’IA est formée sur des infos erronées, elle peut donner de mauvaises réponses.

Pour te donner un exemple concret, un chatbot de recrutement entraîné sur de vieux CVs pourrait favoriser un certain type de profil en excluant d’autres candidats sans le vouloir.

Afin de ne plus rencontrer ce souci, il faut vérifier et filtrer les données utilisées pour l’apprentissage et mettre en place des systèmes de correction et d’ajustement des réponses pour éviter les biais.

À lire aussi

Il peut y aussi avoir des biais médicaux : on en parle plus dans cet article sur l’usage de l’IA dans différents secteurs !

Limitations techniques et coûts énergétiques 💰

Gérer un chatbot IA ultra-performant, ça demande beaucoup de ressources :

- Coût élevé : un modèle comme GPT-4 coûte des millions d’euros à entraîner et à maintenir.

- Consommation énergétique : les serveurs tournent en continu et peuvent avoir une empreinte carbone importante.

Pour palier cela, il faut optimiser les algorithmes pour réduire la puissance nécessaire et utiliser des infrastructures plus écologiques et durables.

Vers des chatbots plus intelligents et plus fiables

Les défis sont nombreux, mais l’IA évolue à une vitesse folle. Voici quelques pistes pour les chatbots du futur :

✅ Mémoire améliorée : pour mieux comprendre le fil d’une conversation.

✅ Meilleure compréhension du contexte et des nuances linguistiques.

✅ Plus de transparence sur les sources utilisées pour éviter la désinformation.

✅ Des modèles d’IA plus responsables et éthiques.

Conclusion : une technologie en constante évolution 📈

Les chatbots IA sont de véritables prouesses technologiques qui révolutionnent la manière dont nous interagissons avec les machines. Grâce à des avancées en traitement du langage naturel (NLP), en apprentissage automatique et en compréhension contextuelle, ils sont capables de tenir une conversation fluide et intuitive.

Mais ils ont encore des limites : mémorisation limitée, difficultés à comprendre certaines nuances, biais algorithmiques et impact environnemental. Heureusement, les chercheurs travaillent d’arrache-pied pour les rendre plus intelligents, plus éthiques et plus efficaces.

Alors, la prochaine fois que tu parleras à un chatbot, tu sauras exactement comment il fonctionne ! 😉